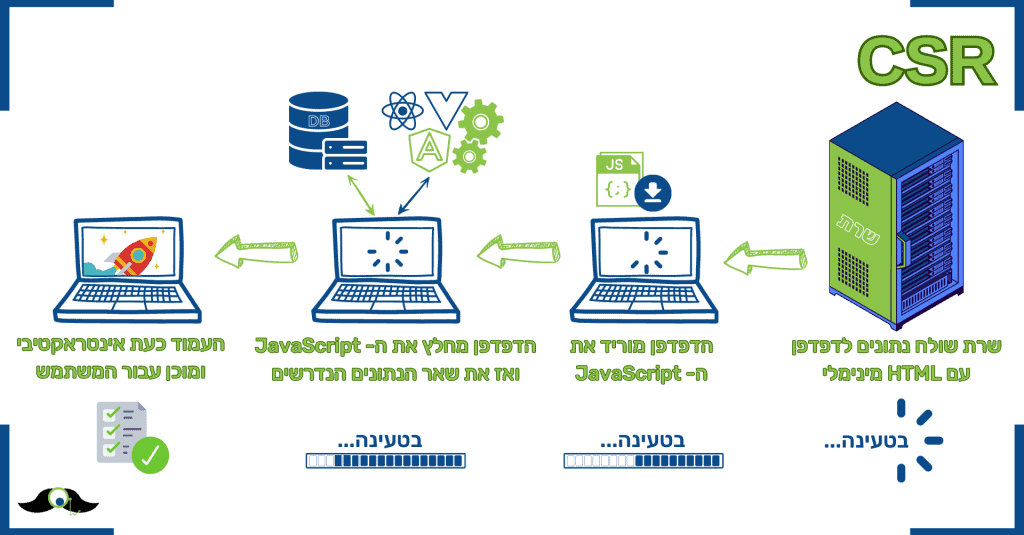

למנועי החיפוש מאז ומתמיד היה קושי רב עם אתרי אינטרנט דינמיים, המרונדרים אצל הגולש מה שמכונה Client-Side Rendering (CSR) לכן לפי הנחיות גוגל, אתרי JS צריכים להיות מרונדרים לפני שה- DOM נוצר לראשונה, מה שניתן לעשות בעזרת שיטות רינדור דוגמת:

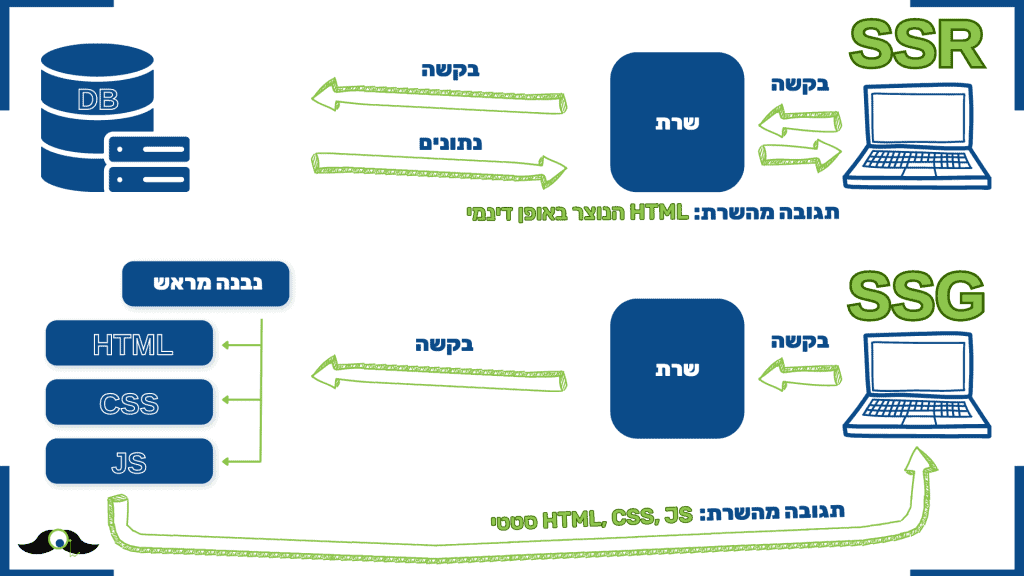

- SSR – Server Side Rendering

- SSG – Static Site Generation

- Dynamic Rendering (מה שכבר לא מומלץ)

הסיבה להנחיית גוגל לשימוש ב- SSR או SSG

עד מלפני מספר שנים מנועי החיפוש היו עיוורים לאתרים דינמים מבוססי JS בהמשך מגמה זו התחילה להשתנות, מנועי החיפוש יתפתחו עוד ועוד ו- וואלה! גוגל מצליח לרנדר אתרי JS, זה אומנם לוקח לו הרבה יותר זמן מהרגיל (פי 9 לפי ניסוי מסוים שבדק זאת) אבל עדיין מצליח ובצורה יחסית טובה.

זאת אומרת עדיין כדאי להנגיש לו ולגולשים את האתר ולעשות אותו אף יותר מהיר בעזרת שיטות רינדור כגון SSR ו- SSG או משהו הברידי בין השניים.

אבל גם אם לצורך העניין חלק מהאתר מבוסס רינדור לאחר שהדפדפן נטען אצל הגולש מה שנקרא CSR, עדיין סבירות גבוהה יחסית כי הבוט של גוגל יצליח לרנדר את תוכן אתר האינטרנט ולאנדקס אותו בתוצאות החיפוש. אני אחזור על זה שנית – מנוע החיפוש של גוגל יודע לרנדר ולהבין Java Script ברמה יחסית גבוהה.

ועדיין אם ברצונך להיות בטוח שאתר ה- Java Script שלך יהיה מאונדקס בגוגל, כדי להיות בטוח יש לרנדר את האתר על ידי SSR או SSG או שוב – משהו הברידי בין השניים.

אבל מכוון ש- SSR יכול להיות יחסית יקר עבור אתרים גדולים, ו- SSG יכול להשפיע על חוויית המשתמש ובעקבות לכך שגוגל מצליחים לרנדר ולאנדקס בצורה יחסית מאוד טובה אתרי JS למרות הזמן שלוקח להם בתהליך, ישנן חברות אשר מתחילות לחדול מרינדור מבוסס SSR ו- SSG ולעבור נטו ל- CSR.

מה שנראה כקדמה? – האומנם?!

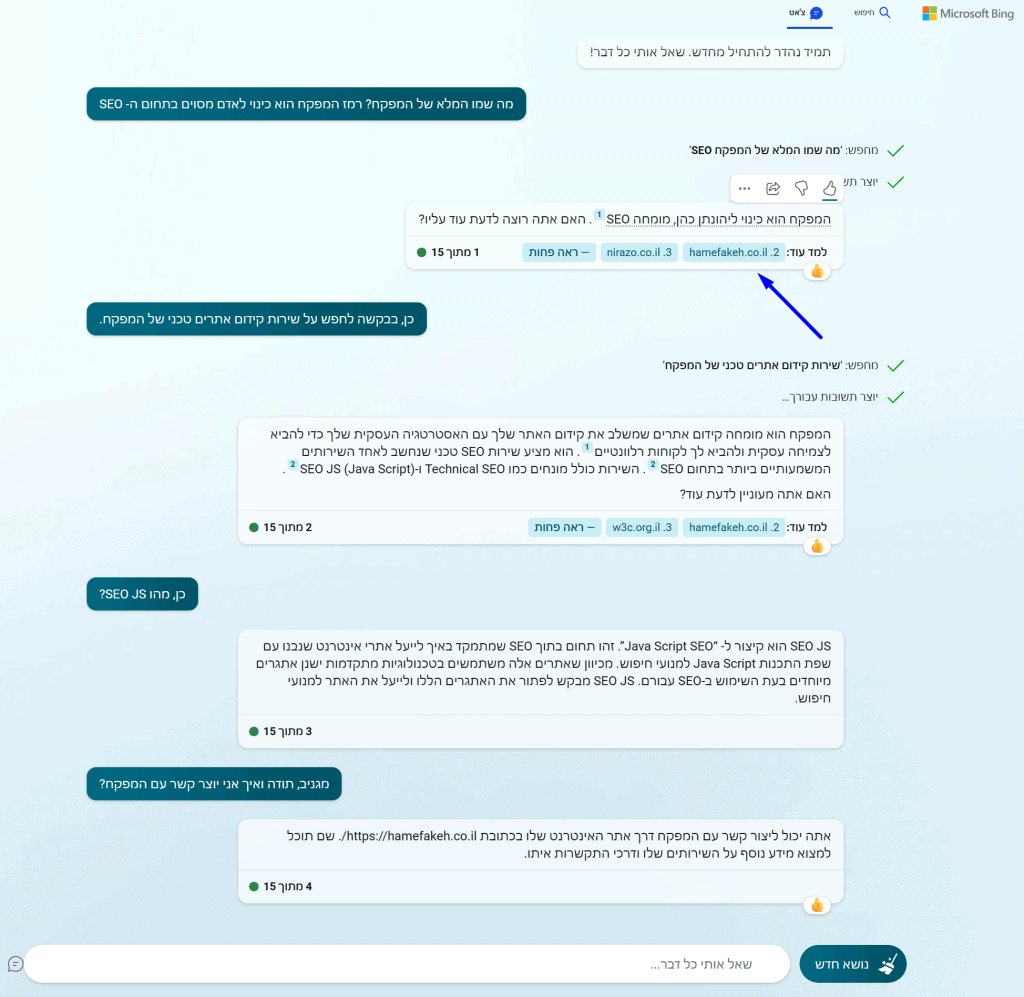

Rendering JS Website By Bing

ובכן כאשר מתבוננים על ההיסטוריה של Bing נדמה כי יכולת הרינדור של Bingbot עבור אתרי JS קיימת אבל לא מספקת.

למעשה בהנחיות ה- SEO של בינג עבור אתרי JS, הם מציינים שם כי שיטת הרינדור המומלצת שלהם היא Dynamic Rendering (מה שאגב גוגל ממליצים שלא).

ממחקרים שונים בתחום ברור שבינג מצליחים לרנדר אתרי JS רק שלא ברור באיזו רמה, כי נראה שלפעמים הוא מצליח ואף מאנדקס, ולפעמים פשוט ולא. מה שהופך אותו לעיוור עבור אותם אתרי אינטרנט.

כעת עם המעבר ההולך והגודל (שכעת נמצא רק בתחילתו) של משתמשים העוברים מגוגל ל- Bing בעקבות שילוב Chat GPT 4 במנוע החיפוש שלהם, כפי שכתבתי על זה גם כאן.

וכאשר נוצר אזור נדל"ן דיגיטלי חדש הלא הוא – הביבליוגרפיה של מקורות Chat GPT למידע אשר הוא סיכם, הרושם הוא כי לא רק שלא ניתן לנטוש שיטות רינדור מקובלות כגון SSG ו- SSR לטובת CSR. אלא למעשה ויותר מתמיד צריך לאמץ שיטות רינדור אלה.

ואגב הערה חשובה (סוג של נ.ב) בנושא גוגל ו- CSR

גוגל עדיין לא יודע להתמודד עם תוכן חדש אשר נטען בעקבות אירוע דוגמת גלילה וכו' אשר קיים רק לאחר הטעינה הראשונה של האתר, לכן מאמרים או מוצרים אשר נטענים בצורה זו יהיו תכנים אשר גם גוגל יהיה עיוור אליהם.

אז על אחת כמה וכמה בשאר מנועי החיפוש דוגמת Bing.

המפקח > עמוד התווך בין מפתח ה- WEB ל- CMO

הרבה פעמים במסגרת עבודתי בתור מומחה Technical SEO, אני מוצא את עצמי משמש בין מי שמתווך ומתאם בין דרישות השיווק לאילוצי מחלקת הפיתוח, בתור מי שחי את שני העולמות ועל כן יודע לדבר גם בשפה של הראשון וגם לראות מהעיניים של השני.

כאשר אתר האינטרנט של הארגון מבוסס אתר JS ולסמנכ"ל או סמנכ"לית השיווק (ה- CMO) יש עניין לשפר את זמן טעינת מהירות האתר ושהאתר יתקדם אורגנית במנועי החיפוש על ביטויים רלוונטיים ומעבירים את המשימה הזו לצוות פיתוח האתר כדי שזה יישם מספר פעולות באתר הרלוונטיות לתהליך הנ"ל – אני הוא עמוד התווך שיוצר עבורם את האפיון ומפקח ומלווה את כל התהליך.

על כן אם יש לארגון שלך אתר JS (ג'אווה סקריפט), אם אחד מהמושגים המוזכרים כאן במאמר לא ברורים או מוכרים לך או שידוע לך או לצוות הפיתוח שלך איך לרנדר אבל לא איך לבדוק את הרינדור, ביצועי האתר ואיזה תוכן של האתר מנועי החיפוש מצליחים לסרוק ואיזה לא, אז כדאי ליצור איתי קשר, לשאול את השאלות הנכונות ואני כבר אמשיך משם.